Stability.aiが日本語画像言語特徴抽出モデル「Japanese Stable CLIP」をリリース

Stability AIは、日本語に特化した画像言語特徴抽出モデル「Japanese Stable CLIP」をリリースしました。このモデルは、ゼロショット画像分類や画像検索などに使用でき、他のモデルと組み合わせることで、text-to-imageやimage-to-textの生成タスクにも応用可能です。

このAIニュースのポイント

- 新モデルのリリース: Stability AIが日本語に特化した画像言語特徴抽出モデル「Japanese Stable CLIP」をリリースしました。

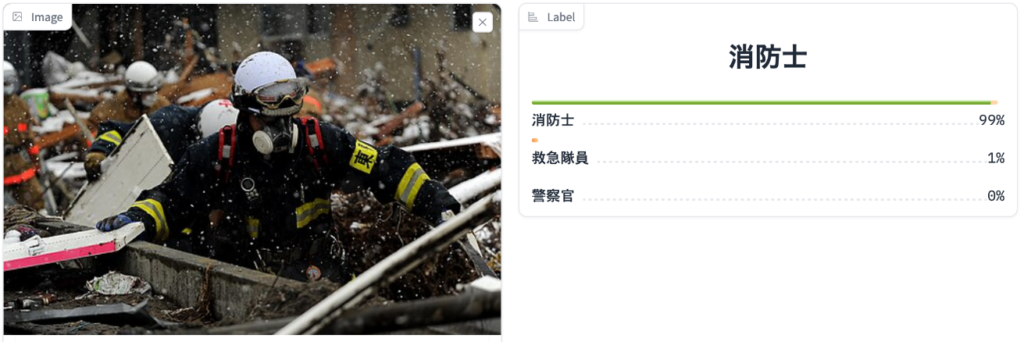

- 用途の多様性: モデルはゼロショット画像分類、画像検索、text-to-image、image-to-text生成タスクなどに使用可能です。

- 日本語と画像の特化: 「Japanese Stable CLIP」は日本特有の画像や日本語に特化しており、関連するタスクにおいて高い性能を発揮します。

- 最新手法の採用: モデル開発には、SigLIPという最新の手法が用いられています。

- 高い性能: このモデルは、オープンソースの日本語対応CLIPモデルの中で最高の性能を示しており、ImageNet top-1の精度で62.06%を達成しています。

- マルチモーダルタスクへの応用: 日本語テキストと画像を組み合わせたマルチモーダルタスクにも応用可能です。

- 学習データの取り扱い: 公開されているコンテンツの取り扱いにおいて、クリエイターのコントロールを重視し、特定のデータを除外しています。

- 日本のAIコミュニティへの貢献: このモデルのリリースにより、日本のAIコミュニティの活性化に貢献することを目指しています。

- 企業情報: Stability AIは、オープンな生成AIを提供する企業で、世界中の公共および民間のパートナーと協力しています。

「Japanese Stable CLIP」は、日本特有の画像や日本語に特化しており、SigLIPという最新手法を用いて開発されました。このモデルは、オープンソースの日本語対応CLIPモデルの中で最高の性能を示しています。具体的には、ImageNet top-1の精度で62.06%を達成しています。

また、このモデルを使用することで、日本語テキストから画像を検索したり、その逆のテキスト検索も可能です。さらに、日本語テキストと画像を組み合わせたマルチモーダルタスクへの応用も可能になります。

Stability AIは、公開されているコンテンツの取り扱いにおいて、クリエイターのコントロールを重視しており、「Japanese Stable CLIP」の学習データは、クリエイターからのオプトアウト要求やrobots.txtなどに基づいて禁止されたデータを除外しています。

このモデルのリリースにより、日本のAIコミュニティの活性化に貢献することを目指しています。Stability AIは、オープンな生成AIを提供する企業であり、世界中の公共および民間のパートナーと協力しています。

詳細情報やモデルの試用については、Stability AIのウェブサイトを参照してください。

出典:Stability.AI